Zurzeit prüfen Forscher neue Formen und Architekturen, um die künftige künstlichen Intelligenz (KI) zu entwickeln. Derzeit sind die wichtigsten Ansätze und die Gestaltung von KI entweder symbolisch (basierend auf Problemdarstellungen, Logik und Suche), Bayes’sche Netze (probabilistisches Modell) oder Deep Learning. Die meisten von uns kennen ein Deep Learning, das eine explizite Vorstellung von Modulen und Unterprogrammen beinhaltet, wie z.B. neuronale Modulnetze oder neuronale Interpreter, wie Google Translate (GT). Diese verwenden ein großes End-to-End-Netzwerk mit langem Kurzzeitgedächtnis, in dem das System „aus Millionen von Beispielen lernt“.

Deep Learning ermöglicht die Funktion Face Unlock unseres Smartphones. Wenn es Deep Learning nicht gäbe, hätten Spotify und Netflix keine Information darüber, was Sie als nächstes hören oder sehen wollen.

Ist es jedoch realistisch, in Zukunft eine andere Architektur zur Erfassung der Kognition zu haben? Oder wie wird die Architektur der Zukunft für die KI aussehen?

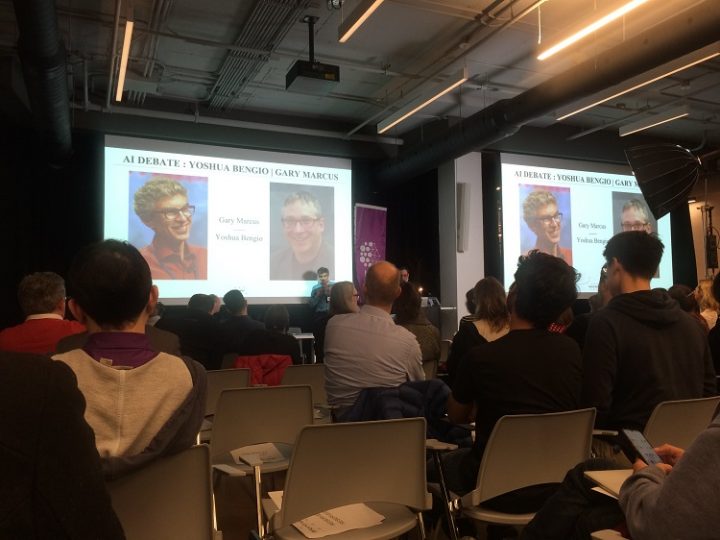

Um diesen Fragen nachzugehen, organisierte das Montreal Institute for Learning Algorithms im Dezember eine Diskussionsrunde mit zwei renommierten Forschern: Gary Marcus, Bestsellerautor, Unternehmer und Yoshua Bengio, Professor an der Universität Montreal, Preisträger des Turing-Preises 2019 (Nobelpreis für Informatik) und Experte für Deep Learning.

Während der Diskussionsrunde waren sich sowohl Gary Marcus als auch Yoshua Bengio einig, dass der Bereich der KI von einer Darlegung ihrer Übereinstimmungen und Verschiedenheiten profitieren könnte. Sie stimmen überein, dass es sowohl aus praktischen als auch aus wissenschaftlichen Gründen wichtig ist, Menschen die Möglichkeit zu geben, künstliche Agenten interaktiv zu trainieren, damit sie Sprachinstruktionen verstehen.

Zurzeit gibt es keine gängigen Lernmethoden, um Agenten der KI für das Verstehen von Anweisungen in menschlicher Sprache auszubilden. Marcus und Bengio waren sich einig, dass dieses Ziel möglicherweise erhebliche Forschungsanstrengungen erfordert. Sie stellen ihre Forschung und verschiedene Modelle zur Entwicklung von Strategien zur Verbesserung der Dateneffizienz über das Sprachenlernen vor.

Laut Bengio hat das Deep Learning große Fortschritte in der Wahrnehmungsfähigkeit gemacht. Eines seiner Hauptanliegen ist es, Algorithmen zu entwerfen, die sich fortgeschrittene Repräsentationen aneignen. Dabei handelt es sich um Repräsentationen, die mit den hochrangigen Konzepten, die wir in der Sprache verwenden, verbunden werden sollten, aber das ist etwas, was wir mit ungesteuertem Lernen noch nicht bewerkstelligen können.

„Um einen Satz in natürlicher Sprache wirklich zu verstehen, braucht man ein System, das versteht, worauf sich die Wörter in dem Satz in der realen Welt beziehen, mit Bildern, Tönen und Wahrnehmung. Eine weitere Idee im vorgängigem Bewusstsein ist es, diese hochrangigen Konzepte und Regeln in den niederen Wahrnehmungen zu verankern. Die Forschungsrichtungen gehen in Richtung geerdetes Sprachenlernen und multimodale Sprachmodelle, bei denen das Lernen nicht nur aus Texten besteht, sondern auch aus deren Assoziationen mit Bildern, Videos und Sinneswahrnehmungen“, so Bengio. (M)

Bengio und Marcus erörtern die Fragestellung: Welchen Weg sollen wir mit KI einschlagen? (Bild von Anne Farrell)

Gary Marcus hat einen anderen Ansatz und sucht nach einer Form, die Kausalität und Logik beinhaltet. „Realistisch betrachtet ist Deep Learning nur ein Teil der größeren Herausforderung, intelligente Maschinen zu bauen. Solche Techniken haben keine Möglichkeiten, kausale Beziehungen darzustellen (…) haben keine offensichtlichen Möglichkeiten, logische Schlüsse zu ziehen, und sie sind auch noch weit davon entfernt, abstraktes Wissen zu integrieren, z.B. Informationen darüber, was Objekte sind, wozu sie dienen und wie sie typischerweise verwendet werden. (Wikipedia)

Während der Debatte erklärt Bengio kurz seine neue Forschungsarbeit, die auch eine lernende Wiedergabe von hochrangigen Konzepten beinhalten. Es wäre eine Art von Konzept, das mit Sprache manipuliert und abstraktes Wissen integriert. Bengio bezeichnet dieses Modell als vorheriges Bewusstsein.

Nach der Debatte führte ich einige Untersuchungen durch, um die Beziehung zwischen Deep Learning und vorgängiges Bewusstsein mit der menschlichen Kognition besser zu verstehen.

Deep Learning und vorgängiges Bewusstsein in Bezug auf die menschliche Kognition

Das Deep Learning ist eng mit einer Klasse von Theorien der Gehirnentwicklung (insbesondere der neokortikalen Entwicklung) verbunden, die von den kognitiven Neurowissenschaftlern Anfang der 1990er Jahre vorgeschlagen wurden. Es wurde eine Vielzahl von Ansätzen verwendet, um die Plausibilität von Modellen des Deep Learnings aus neurobiologischer Perspektive zu untersuchen. Obwohl ein systematischer Vergleich zwischen der Organisation des menschlichen Gehirns und der neuronalen Kodierung in tiefen Netzwerken noch nicht etabliert ist, wurde über mehrere Analogien berichtet. Zum Beispiel könnten die Berechnungen, die von tiefen Lerneinheiten durchgeführt werden, denen von tatsächlichen Neuronen und neuronalen Populationen ähnlich sein. Entsprechend ähneln die von tiefen Lernmodellen entwickelten Darstellungen denen, die im visuellen System der Primaten sowohl auf der Ebene der einzelnen Einheiten als auch auf der Ebene der Population gemessen werden. (Wikipedia)

Das Modell von Bengio ist mit der Theorie des globalen Arbeitsraums des Bewusstseins verwandt. Der Bengio-Ansatz basiert auf der Idee eines Anreizregulators für Repräsentationen und zwingt sie dazu, die Eigenschaft zu haben, dass wir nur einige wenige Dimensionen auf einmal extrahieren und kraftvolle Vorhersagen über die Zukunft machen können. Es ist eine Möglichkeit, dem Lernen von Repräsentationen eine zusätzliche Einschränkung hinzuzufügen, so dass sie das klassische symbolische Wissen der KI gut ausdrücken können. Die Frage, die Bengio während der Debatte stellte, war die nach der „Aufrechterhaltung der Aufmerksamkeit“. Wie wäre es beispielsweise möglich, dass ein Lerneinheit kontinuierlich lernt, die Zuordnung anpasst und gleichzeitig den höheren Ebenen ermöglicht, ihre Verständnis der unteren Ebene beizubehalten?

In seiner Forschung nannte er das Beispiel: „Überlegen Sie sich hervorzusagen, ob ein Stapel von Blöcken auf einen Tisch fallen oder von ihm fallen wird. Es handelt sich um ein Ergebnis, das leicht vorhergesagt werden kann, auch wenn die Details, wo die Blöcke fallen werden, auch für Menschen schwer vorhersehbar sind. In diesem Fall wäre die Vorhersage der Zukunft auf Pixelebene äußerst schwierig, da zukünftige Zustände eine hohe Entropie mit einer stark multimodalen Verteilung aufweisen. Einige Aspekte der Zukunft könnten jedoch eine niedrige Entropie aufweisen. Wenn diese Aspekte außerdem einen großen Einfluss auf die Vorhersage dessen haben, was als Nächstes kommt (oder darauf, jetzt die richtigen Entscheidungen zu treffen), dann sollte die Bewusstseinspriorität sehr nützlich sein“. (Bengio, 2017)

Aus meiner Studie über den Mechanismus des Bewusstseins und das Gefühl der Präsenz und des Eintauchens, das die Benutzer bei der Interaktion im virtuellen Raum empfinden (Farrell, 2008), geht hervor, dass Forscher einiges zu gewinnen haben, wenn sie die herausragende Arbeit von Mario Robriguez Cobos (Silo) genauer unter die Lupe nehmen. Cobos arbeitet an der Aktivität des Bewusstseins und erklärt, dass das Bild eine aktive Form ist, die das Bewusstsein (als Struktur) in der Welt platziert. In der Psychologie des Bildes beschreibt Cobos, wie das Bild auf den Körper und den „Körper in der Welt“ aufgrund einer Intentionalität einwirkt, die nach außen gerichtet ist und nicht einfach einem Für-sich oder einem „natürlichen“, reflektierten und mechanischen In-Sich selbst entspricht. Das Bild agiert innerhalb einer zeitlich-räumlichen Struktur und innerhalb einer inneren „Räumlichkeit“, die daher als „Vorstellungsraum“ bezeichnet wurde. Die verschiedenen und komplexen Funktionen, die das Bild ausübt, hängen im Allgemeinen von der Position ab, die es innerhalb dieser Räumlichkeit einnimmt.

In der Arbeit „Beiträge zum Denken“ liefert Cobos (Silo) eine ausführlichere Erklärung der Theorie des Vorstellungsraums. Seine Arbeit erforscht auch den grundlegenden Mechanismus des Bewusstseins und die Einordnung der Aufmerksamkeit in eine höhere Ebene der Vorhersage. Cobos nannte es die Umkehrbarkeit des Bewusstseins, d.h. die Fähigkeit des Bewusstseins, sich mittels der Aufmerksamkeit auf die Informationsquellen zu richten. So führen die reversiblen Mechanismen für die Sinne zu dem, was er Apperzeption nannte, und für das Gedächtnis zu einem Wachrufen. Die Funktionsweise der umkehrbaren Mechanismen steht in direkter Beziehung zur Ebene des Bewusstseins; je höher man aufsteigt, desto mehr funktionieren sie, und je niedriger man absteigt, desto weniger funktionieren sie. Natürlich erfordern die Konzepte und die Theorie von Cobos ein Verständnis der Theorie des Bewusstseins, die in der Psychologie des neuen Humanismus beschrieben wird.

Über Deep Learning

Deep Learning ist eine nützliche Komponente des maschinellen Lernens, die es der künstlichen Intelligenz ermöglicht, Daten und Informationen so zu sortieren, dass sie das neuronale Netzwerk des menschlichen Gehirns nachbildet. Anstatt Algorithmen einfach nur zu Ende zu führen, können wir beim Deep Learning die Parameter eines Lernsystems so lange verändern, bis es die gewünschten Ergebnisse liefert. Im Jahr 2019 ging der Turing Award, der für herausragende Leistungen in der Forschung im Bereich der künstlichen Intelligenz vergeben wird, an drei der einflussreichsten Architekten des Deep Learning: Yann LeCun von Facebook, Geoffrey Hinton von Google und Professor Yoshua Bengio. Dieses Trio hat zusammen mit vielen anderen im letzten Jahrzehnt die Algorithmen, Systeme und Techniken entwickelt, die für den Ansturm von KI-gestützten Produkten und Dienstleistungen verantwortlich sind. (TNW)

Aus dem Englischen übersetzt von Anita Köbler vom ehrenamtlichen Pressenza-Übersetzungsteam. Wir suchen Freiwillige!